语言的机器革命:大语言模型的技术原理与应用前景

2025-11-21 21:14

栏目: 行业动态

查看(

)

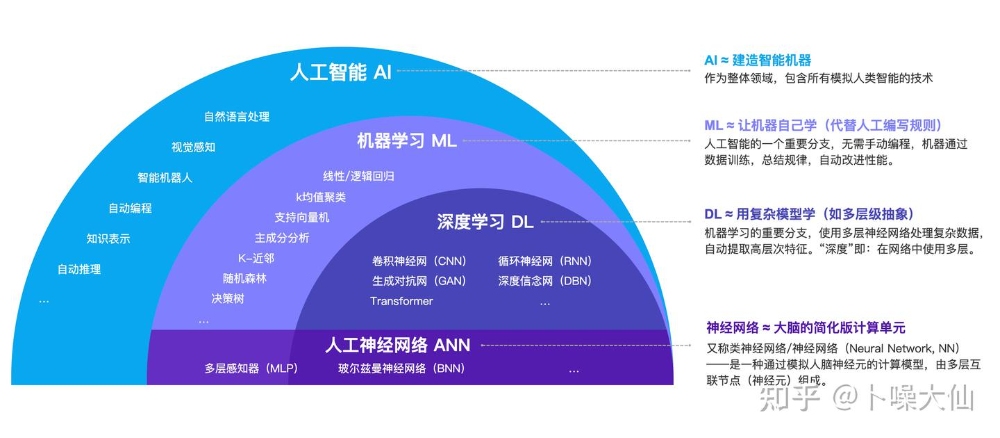

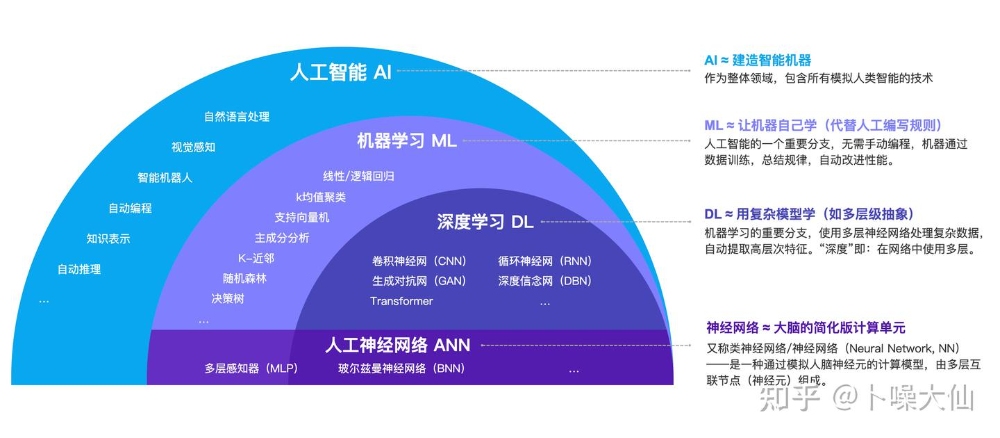

大语言模型(Large Language Models, LLMs)正以前所未有的方式重塑着人工智能的边界。从ChatGPT到Claude,从GPT-4到Gemini,这些拥有千亿甚至万亿参数的神经网络,正在重新定义机器理解和使用人类语言的能力。

大语言模型的技术基石

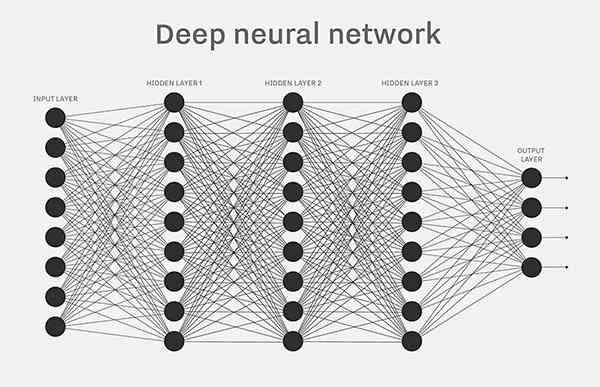

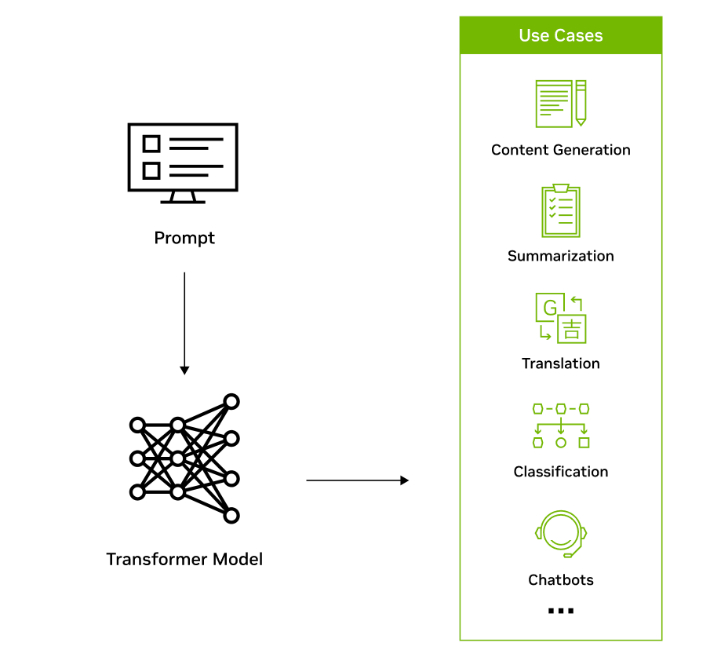

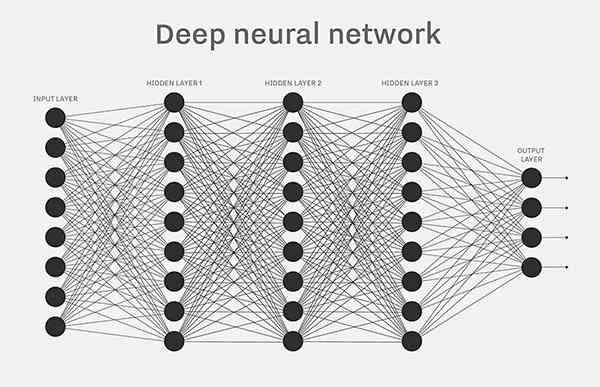

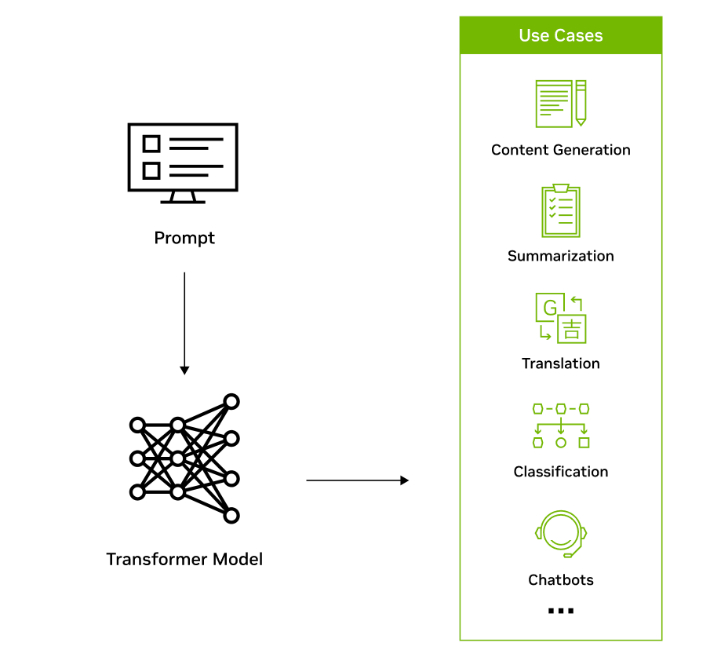

大语言模型的核心技术架构建立在Transformer神经网络之上,这种革命性的架构彻底改变了自然语言处理的范式。

Transformer架构的突破:

Transformer架构于2017年由Google研究团队提出,其"自注意力机制"(Self-Attention Mechanism)解决了传统循环神经网络在处理长序列时的梯度消失问题。架构中的多头注意力(Multi-Head Attention)让模型能够并行处理序列中的不同位置信息,大大提升了训练效率和模型性能。

参数规模的指数增长:

大语言模型的参数数量呈现指数级增长趋势:

- GPT-1:1.17亿参数

- GPT-2:15亿参数

- GPT-3:1750亿参数

- GPT-4:推测万亿级参数

- PaLM:5400亿参数

- Claude:万亿级参数

这种规模的增长不仅是数量上的突破,更重要的是带来了"涌现能力"(Emergent Abilities)的出现,即模型在达到某个规模阈值后,突然展现出此前不具备的高级能力。

预训练与微调的范式:

现代大语言模型采用"预训练-微调"的范式:

- 预训练阶段:模型在海量无标注文本上学习语言的统计规律和知识

- 微调阶段:通过少量标注数据让模型适应特定任务和领域

- 提示工程(Prompt Engineering):通过精心设计的提示词来引导模型产生期望的输出

涌现能力的科学奇迹

大语言模型最令人着迷的特性是"涌现能力"——当模型参数规模达到某个临界点时,会突然展现出令人惊讶的高级能力。

理解与推理能力的跃升:

- 常识推理:模型能够运用日常生活中的常识进行逻辑推理

- 数学计算:虽然训练数据中数学内容相对较少,但模型展现出惊人的数学能力

- 因果推理:能够理解事件之间的因果关系,而非仅仅基于表面关联

创造性与原创性:

- 文学创作:能够创作诗歌、小说、剧本等各种文学作品

- 代码生成:不仅能理解编程语言,还能创造性地解决编程问题

- 多语言生成:能够理解和生成多种语言的文本,展现出跨语言的理解能力

知识整合与总结能力:

- 信息综合:能够从多个来源整合信息,生成综合性的观点

- 知识转移:能够将一个领域的知识应用到另一个领域

- 概念抽象:能够从具体事例中抽象出一般性的概念和原理

少样本学习(Few-shot Learning):

即使只有很少的示例,模型也能快速学会新的任务模式,这种能力在传统的机器学习方法中很难实现。

训练过程的复杂性挑战

大语言模型的训练过程是一个极其复杂和资源密集型的工程挑战。

数据准备的挑战:

- 数据清洗:需要从海量互联网文本中筛选出高质量的训练数据

- 去重处理:避免重复数据对训练过程的负面影响

- 多样性保证:确保训练数据涵盖各种语言风格、主题和领域

- 隐私保护:在利用公开数据的同时保护个人隐私信息

计算资源的需求:

- 算力需求:训练GPT-3级别的模型需要数千张GPU同时工作数周时间

- 能耗问题:巨大的能耗引起了环保担忧,推动了更高效训练方法的研究

- 硬件优化:需要专门的AI芯片和大规模集群来支持训练过程

训练技巧的创新:

- 混合精度训练:使用不同精度的数值表示来加速训练过程

- 分布式训练:将模型和数据分布在多个设备上并行训练

- 梯度累积:通过累积多个小批次的梯度来模拟大批次训练

- 学习率调度:动态调整学习率以获得更好的训练效果

模型压缩与优化:

- 知识蒸馏:通过训练小模型来模拟大模型的行为

- 量化技术:减少模型参数的精度以降低存储和计算需求

- 剪枝技术:移除对性能影响较小的参数和连接

实际应用场景的深度渗透

大语言模型正在各行各业创造着前所未有的应用价值,从内容创作到代码生成,从教育培训到医疗诊断。

内容创作领域的革命:

- 新闻写作:自动生成新闻稿件、报告摘要和数据分析

- 创意写作:协助作家进行故事构思、情节发展和对话创作

- 营销文案:生成广告文案、产品描述和营销材料

- 学术写作:协助研究人员进行论文写作、文献综述和语言润色

代码开发的赋能:

- 代码生成:根据自然语言描述自动生成代码

- 代码审查:自动识别代码中的错误和潜在问题

- 文档生成:自动生成API文档和代码注释

- 调试助手:协助开发者诊断和修复代码问题

教育与培训的革新:

- 个性化教学:根据学生的学习特点提供定制化的学习内容

- 智能问答:回答学生在各个学科领域的疑问

- 语言学习:提供多语言的语法检查和表达建议

- 技能培训:协助职业技能培训和专业发展

商业决策的支持:

- 市场分析:分析和总结市场趋势、竞争情报和消费者反馈

- 风险评估:识别和评估各种商业风险和机遇

- 客户服务:提供24/7的智能客服和咨询支持

- 战略规划:协助企业制定战略决策和发展规划

科研与创新的加速:

- 文献综述:快速总结和比较大量学术文献

- 假设生成:协助研究人员提出新的科学假设

- 实验设计:帮助设计实验方案和分析实验结果

- 跨领域创新:促进不同学科之间的知识融合

技术局限与挑战

尽管大语言模型展现出令人惊叹的能力,但仍面临诸多技术挑战和局限性。

幻觉问题(Hallucination):

模型有时会生成看似合理但实际上不准确的信息,这被称为"幻觉"现象。这种问题在需要高准确性的应用中尤为严重。

知识截止时间:

大语言模型的训练数据存在时间截止点,无法获取训练完成后的最新信息。这限制了其在快速变化领域的应用。

上下文长度限制:

模型一次能够处理的文本长度有限,虽然最新的模型已经扩展到数万字,但仍无法处理超长的文档或持续进行的对话。

计算成本:

大模型的推理计算成本较高,对实时应用提出了挑战。需要通过模型优化、硬件加速等技术来降低推理成本。

安全与滥用风险:

- 恶意用途:可能被用于生成虚假信息、恶意代码或其他有害内容

- 偏见传播:可能延续训练数据中的社会偏见和刻板印象

- 隐私泄露:在处理个人信息时可能面临隐私泄露风险

可解释性问题:

大语言模型的决策过程仍然不够透明,难以解释模型为何产生特定的输出,这限制了其在需要高度可解释性的领域的应用。

郑重申明:帝往信息科技有限公司以外的任何单位或个人,不得使用该案例作为工作成功展示!